Professor Wansink en de datadetectives (1)

Interview met Tim van der Zee

Ongeveer de helft van alle wetenschappelijke artikelen bevat grote en kleine fouten en statistische onregelmatigheden. Maar in sommige artikelen staan er wel heel veel. Verdacht veel…

door Pepijn van Erp, Skepter 30.4 (2017)

EEN jaar geleden begon het balletje voor de Amerikaanse hoogleraar voedingspsychologie Brian Wansink de verkeerde kant op te rollen. Hij had dat balletje zelf een zet gegeven, door op zijn website openhartig te vertellen hoe het toegaat op zijn instituut. Het onderzoek van de auteur van de bestseller Mindless eating en winnaar van een IgNobelprijs blijkt aan alle kanten te rammelen, en het ziet ernaar uit dat hij ook nog op grote schaal zijn eigen geschriften recyclet. De eerste problemen werden geconstateerd in een aantal artikelen die draaiden om onderzoek uitgevoerd in een Italiaans ‘all-you-can-eat-restaurant’, vandaar dat de affaire inmiddels ook wel met ‘pizzagate’ aangeduid wordt. De onttakeling van het oeuvre van Wansink heeft een Nederlands kantje. Van de drie speurders die pizzagate in gang zetten, zijn er twee in ons land aan het promoveren. Skepter sprak met Tim van der Zee (Leiden) en Nick Brown (Groningen) — hieronder het gesprek met Van der Zee (verschenen in Skepter) en het interview met Brown vindt u hier.

Ik ken je een beetje van je weblog Skeptical scientist, maar wat doe jij eigenlijk in het normale leven?

Ik werk bij het ICLON, een onafhankelijk orgaan aan de universiteit. Binnen mijn afdeling wordt veel onderzoek gedaan naar het ontwikkelen van leraren — de lerarenopleiding zit hier ook. Mijn eigen onderzoek gaat over onlineonderwijs, en dan voornamelijk de kwaliteit van de instructie, van de video’s die gebruikt worden. Ik ben intussen in het derde jaar van mijn promotietraject.

De affaire-Wansink lijkt nogal ver af te staan van die onderwerpen. Hoe ben je daar ingerold?

Mijn hoofdonderzoek is dus dat open onlineonderwijs, daar heb ik mijn baan in. Maar ik zeg altijd: ‘mijn beroep is wetenschapper’. Ik ben al langer geïnteresseerd in de methodologie, vooral in het gebruik van statistiek in de bewijsvoering. Wanneer hebben we iets bewezen, wanneer niet? Wat voor fouten maken mensen? Vandaaruit is deze tijdsbesteding ontstaan.

Bij Wansink is het eigenlijk een opeenstapeling van toevalligheden geweest. Sinds het begin van mijn PhD-traject ben ik actief op Twitter om te netwerken en om input te krijgen van andere wetenschappers. Op een dag, december vorig jaar, deelde iemand een blogpost van Wansink zelf met een heel kritische opmerking daarbij.

Dat was van iemand die jij volgde?

Ja, of van iemand die het retweette. Ik ging dat blog lezen en er waren twee dingen die me opvielen. Ten eerste de beschrijving van de bizarre werkomstandigheden in het lab van Wansink. Een onbetaalde onderzoeksassistente moest alles doen wat Wansink haar opdroeg en het was heel goed dat zij tegen alles ‘ja’ zei, want het had haar vijf publicaties in korte tijd opgeleverd. Een post-doc die daarentegen niet zomaar meeging in zijn voorstellen om in de data te gaan zitten vissen naar verbanden, werd bekritiseerd. Daar vielen veel mensen over.

Maar het andere punt was de manier waarop Wansink blijkbaar onderzoek doet in zijn lab. Er kwamen reacties in de trant van ‘dit is zo’n schoolvoorbeeld van statistisch gefoezel, het kan haast niet echt zijn’.

In mijn directe omgeving dachten de meeste mensen dat je sinds het uitbreken van de replicatiecrisis in de psychologie toch meteen zou moeten zien dat dit niet in de haak was. Het stuk moest satire zijn. Maar dat bleek niet het geval.

Wansink had ook referenties naar die vijf artikelen onderaan zijn bericht geplaatst, haast een uitnodiging om die eens goed te bestuderen. Normaal lees je een wetenschappelijk artikel en vraag je je misschien af hoe het onderzoek tot stand is gekomen, hoeveel vrijheid iemand zich heeft veroorloofd om tot het resultaat te komen. In dit geval kenden we de ontstaansgeschiedenis al.

Samen met Nick Brown en Jordan Anaya ging je die artikelen toen uitpluizen. Kenden jullie elkaar al?

Nick kende ik al goed via Twitter, Jordan nog niet. Wie de eerste statistische fouten ontdekte, weet ik niet meer precies, maar toen we met die blik gingen kijken, ontdekten we er snel meer. Eerst deelden we dat nog publiekelijk, maar al snel zijn we via privékanalen onze bevindingen gaan uitwisselen.

Had je toen al een idee van de status van Wansink?

Nee, totaal niet. Ik zag wel dat hij hoogleraar was aan Cornell University, maar dat zei me ook weinig. In december en begin januari waren we druk bezig met onderzoek en toen ging ik zeven maanden naar de Verenigde Staten. Daar kwam ik erachter dat Cornell een topuniversiteit is, en dat Wansink binnen zijn vakgebied een grootheid is. En dat hij ook directeur was geweest van een belangrijk overheidsorgaan dat zich bezighoudt met voedselbeleid.

Hebben jullie ook contact opgenomen met Wansink?

Vrij snel nadat we fouten ontdekt hadden, hebben we gevraagd om de oorspronkelijke gegevens. De tijdschriften waarin de artikelen waren verschenen, hanteren het principe dat data op aanvraag beschikbaar moeten worden gesteld. Ik heb toen een heel correct verzoek ingediend bij het lab, maar kreeg als antwoord dat ze de data niet konden vrijgeven in verband met de privacy. Ze bleven er moeilijk over doen, ook toen ik zei dat ik niet geïnteresseerd was in de privacygevoelige details, die toch makkelijk weggelaten konden worden. Uiteindelijk reageerde Wansink waarschijnlijk zelf toen ik opmerkte dat ik wat onregelmatigheden had gezien. Heel interessant wat ik ontdekt had, zei hij, en hij bood aan om samen een artikel te schrijven, bijvoorbeeld over wanneer je welke statistische methoden moet gebruiken. Ik weet niet of dat een oprecht aanbod was of dat hij probeerde me in te palmen. Hij reageerde niet meer toen ik antwoordde dat ik alleen die data graag wilde hebben.

Toen besloten jullie de bevindingen in de vorm van een wetenschappelijk artikel te gieten?

We wilden er eerst over schrijven op onze blogs. Maar het werd zo enorm uitgebreid dat we besloten het als een artikel op te schrijven en als een preprint te publiceren — dan konden we het altijd nog insturen naar een tijdschrift.

Daarna ging het snel. Binnen twee, drie weken hadden tienduizend mensen die preprint gelezen, dat is extreem veel. Toen waren er ook nog wel gemengde reacties — ‘Moet je wel zo kritisch zijn? Het is ook niet per se fraude,’ of ‘Het kan toch ook gewoon slordigheid zijn?’ — maar toen van Wansink het ene na het andere artikel met problemen volgde, was de algemene reactie wel: ‘Dit is bizar.’

We hadden ons eerst gericht op alleen die ‘pizza-papers’ en vroegen ons al wel af wat de gemeenschappelijke factor was. Was het toevallig? Lag het aan die assistente? Aan de data? Of lag het aan Wansink zelf? Toen zijn we meer artikelen van Wansink gaan bekijken, en vonden vooral Nick en Jordan aan de lopende band fouten en identieke passages — ons contact bestond een tijdlang uit berichtjes als ‘O, ik heb weer een fout gevonden.’ Toen wisten we dat het geen toeval was: dit was Wansink. Het was systematisch.

Kregen jullie nog input van anderen?

We hebben goede feedback gekregen van mensen die we op de hoogte hielden, maar we kregen ook wel anonieme mailtjes waarin werd gevraagd om bepaalde coauteurs van Wansink eens onder de loep te nemen. Veel reacties op onze blogs en via Twitter waren een soort verzoeknummers: ‘Heb je dit artikel al bekeken?’ Ook van wetenschapsjournalisten.

Ben je tevreden over de gang van zaken tot dusver?

Er is gelukkig weinig waarvan ik achteraf denk dat ik het anders had moeten doen. Bij andere recente affaires is kritiek wel eens opgevat als een heksenjacht, maar bij Wansink zijn het zoveel artikelen dat wel duidelijk is dat het ons om zijn werkwijze te doen is en niet om zijn hoofd.

Maar er waren vast ook negatieve reacties.

Met name in het begin. Ook goedbedoelde adviezen dat het misschien slecht voor onze carrière zou kunnen zijn. En verwijten dat anderen op een verkeerde manier kritisch waren of een verkeerde toon aansloegen, en dan bij ons aanklopten daarover. Maar later kregen we dat soort geluiden eigenlijk niet meer. Heel veel mensen die in het begin zeiden dat ze Wansink nog het voordeel van de twijfel gunden, zijn inmiddels om. Iemand die nu nog aarzelt, verwijs ik naar mijn blog, en dan is de reactie eigenlijk altijd: ‘O, je hebt helemaal gelijk.’

De reacties van de tijdschriften waarin Wansinks artikelen staan, zijn heel wisselend tot nu toe.

In het begin waren ze heel erg terughoudend en dat hadden we ook wel verwacht. We vonden toch dat we netjes moesten berichten over onze bevindingen. Op een gegeven moment zagen redacteuren, mede door de aandacht in de media voor de affaire, dat ze er wel iets mee moesten doen. Je ziet nu trouwens dat de meeste intrekkingen van artikelen en correcties vanuit de redacties van tijdschriften komen.

Ik heb wel de indruk dat de media-aandacht cruciaal is geweest. Als Wansink een kleine vis was geweest, zou er dan ook wat zijn gebeurd?

Wansink is een probleem op zichzelf, maar het is ook symptomatisch voor een bredere kwestie, dat hele replicatiegedoe en de lage kwaliteit van veel gepubliceerde artikelen. En er zijn geen gebaande paden om dit soort constructieve kritiek te uiten. Wij dachten dat je het best eerst contact kunt opnemen met de auteur. Maar dan gebeurt er niets. Dan neem je contact op met de redactie van het tijdschrift. En als die niets doet, wat dan? Je kunt nog het integriteitsorgaan van de universiteit mailen, maar als dat niets doet? Al die opties liggen helemaal buiten je invloed, al die instellingen hebben geen enkele reden om erop in te gaan.

Het laatste middel dat je dan hebt, is de publiciteit zoeken met blogposts en preprints. Maar als het niet zo’n bekende onderzoeker was geweest, was het dan wel zo viral gegaan? Of als het niet ging om een onderwerp waarover iedereen wel een idee kan vormen, maar om heel ingewikkeld fundamenteel onderzoek? Dan vast ook niet. Het is in dit geval goed gegaan: mede door alle aandacht zijn er nu al een aantal retracties en correcties gekomen en als het goed is komen er nog veel meer. Maar het is zorgwekkend dat die aandacht nodig is om dit gedaan te krijgen.

De fouten in de artikelen van Wansink vallen snel op voor iemand die er oog voor heeft. Hoe kan het dat dit pas nu naar buiten komt? Zeker als je ziet hoe vaak die artikelen geciteerd zijn. Hebben de auteurs die zijn werk citeren die artikelen wel gelezen?

Ja, het is bizar. En ze zijn ook nog door de peer-review gekomen! Dat moet toch niet kunnen. Er wordt gewoon niet goed naar gekeken. Ik denk wel dat het verandert nu er meer software komt waarmee de statistiek in wetenschappelijke artikelen snel kan worden gecontroleerd. En een nieuwe generatie van wetenschappers die er vanaf het begin van hun carrière mee bekend raken.

Pizzagate

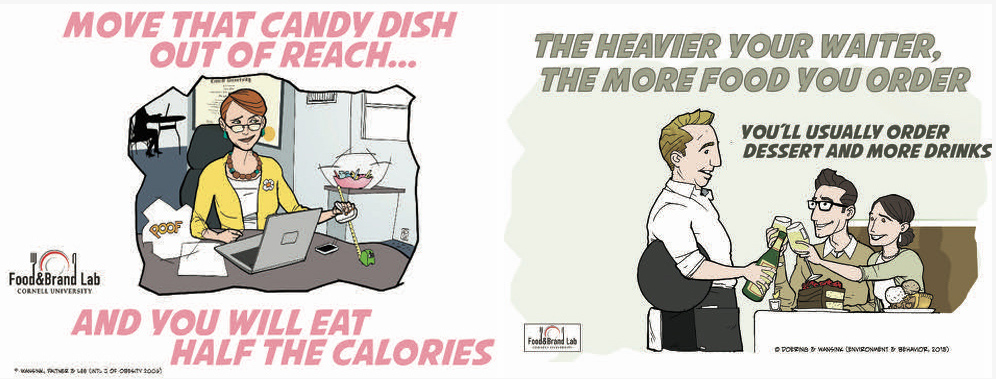

Wansinks pizzagate heeft niets te maken met de hoax tijdens de Amerikaanse verkiezingen over een pedofielennetwerk in de kelder van een Italiaans restaurant. Alleen het soort restaurant komt overeen. Zijn onderzoek was in 2014 in eerste instantie opgezet om eerder onderzoek te repliceren. Dat mislukte, maar Wansink had genoeg ideetjes om toch wat met de data te doen. Dat leidde tot artikelen als ‘Lower buffet prices lead to less taste satisfaction’, ‘Peak-end pizza: Prices delay evaluations of quality’ en ‘Eating heavily: Men eat more in the company of women’.

Twee dingen gaan hier duidelijk mis: het negatieve hoofdresultaat wordt verdonkermaand, en het verder spelen met de data gebeurt zonder voorbehoud, ondanks het risico op het vinden van verbanden die er in werkelijkheid niet zijn. Een enkel voorbeeld van de talloze rekenfouten: als er staat dat van 62 personen 57,4% man is, dan kan dat niet kloppen, want 35/62 = 56,5% en 36/62 = 58,1%.

Welk geval is eigenlijk schokkender: Wansink of Stapel? Zijn die affaires vergelijkbaar?

Er is wel een belangrijk verschil. Bij Stapel draaide het om pure fraude, verzonnen resultaten. Bij Wansink hebben we daar niet genoeg aanwijzingen voor gevonden. En Stapel begreep waarschijnlijk drommels goed hoe het hoorde, bij Wansink krijg je, als je zijn reacties op de kritiek leest, sterk de indruk dat hij eigenlijk helemaal niets begrijpt van statistiek. Grappig is wel dat ze allebei volhouden dat hun conclusies nog steeds kloppen en ook niet het gevoel lijken te hebben dat ze slecht bezig waren.

Wat is het meest opmerkelijke dat je bent tegengekomen in deze affaire?

Toch wel het artikel waarin ze onderzochten of kinderen eerder geneigd zijn om voor een appel in plaats van een koekje te kiezen als je er een vrolijk stickertje op plakt. Dat artikel is eerst ingetrokken en gelijk vervangen, en daarna alsnog helemaal ingetrokken. Het bleek dat het niet ging om kinderen van acht tot elf jaar, zoals ze ook in tweede instantie volhielden, maar om peuters van drie tot vijf jaar. Daar kwamen we achter toen de data werden vrijgegeven na die vervanging. In het Excel-bestand stond commentaar over de deelnemertjes als ‘in slaap gevallen’ of ‘huilde de hele tijd’, waaruit meteen duidelijk was dat het om veel jongere kinderen moest gaan.

Mij viel op dat het in al die artikelen niet duidelijk is dat het vaak om dezelfde data gaat en dat de onderzoekers ook zelf niet meer weten hoe die precies zijn verzameld.

Nee, de data staan ergens op een harde schijf van een wetenschapper en ze zijn na een jaar al niet meer te interpreteren. En als je om de data vraagt, blijken ze misschien nog wel eens door de hond opgegeten. Artikelen staan of vallen met de data. Ik snap dat niet iedereen alle data meteen kan vrijgeven, maar zet ze dan ergens beveiligd online, op zo’n manier dat een onafhankelijke onderzoeker er later ook nog wijs uit kan.

Is er iets voor te verzinnen dat dit soort kritische analyses van buitenstaanders, wetenschappers uit een ander vakgebied of wetenschapsbloggers beter worden opgepikt? Want zelfs als je de stap zet om auteurs, of de tijdschriften, aan te schrijven gebeurt er maar zelden iets mee.

Ik heb daar heel veel ideeën over. Op veel fronten moeten er zaken veranderen. Om te beginnen met die tijdschriften. Die zouden als uitgangspunt moeten hanteren dat ze replicaties van onderzoeken die ze hebben geplaatst ook publiceren. En dat ze die niet weigeren omdat ze niets nieuws zouden brengen. Dat gebeurt nu wel, en die replicatiestudies krijg je dan vaak alleen in tijdschriften van lagere kwaliteit gepubliceerd.

Een tweede punt is dat onderzoekers veel meer zouden kunnen luisteren naar kritiek, voor wat wel post publication peer-review genoemd wordt. Je hebt daar nu wel een onafhankelijk platform voor, pubpeer.com, en het is hartstikke goed dat het er is als tussenoplossing, maar tijdschriften zouden er zelf veel meer open voor moeten staan.

Ook in het beleid rond peer-review moet veel veranderen. Er moet een duidelijk protocol komen voor het controleren van artikelen. Dat je niet aan reviewers vraagt: ‘Kijk ernaar en zeg maar wat je ervan vindt’, maar ‘Heb je de statistiek gecheckt met de beschikbare middelen?’ en ‘Geef aan of de statistiek controleerbaar is.’ De data moeten op zijn minst beschikbaar zijn voor de peer-reviewers, die moeten in staat zijn om de analyse te reproduceren. We doen nu wel alsof dat gebeurt, maar eigenlijk controleren we het niet.

Om dat valideren van wetenschap mogelijk te maken, moet je ook het proces van peer-review inzichtelijk maken, opengooien. Dat gebeurt overigens al wel her en der: een van de artikelen in pizzagate staat in een tijdschrift met openbare peer-review. Die konden we dus teruglezen en zien dat al die fouten inderdaad niet opgemerkt waren.

Gaan dit soort initiatieven echt genoeg gewicht in de schaal leggen om tijdschriften te bewegen in actie te komen als er iets gevonden wordt?

Waar ik al eerder op wees is dat de incentives moeten veranderen. Je kunt denken aan ranglijsten die laten zien hoeveel een tijdschrift aan open science doet.

In financiering van onderzoek moeten er meer eisen gesteld worden aan het openbaar maken van data, zoals NWO nu al doet. Dat zou op veel grotere schaal moeten gebeuren.

Het is ook een cultuurverandering, waar generaties wetenschappers overheen gaan. Wat dat betreft ben ik skeptisch dat het binnen een termijn van een paar jaar verandert, zoals sommigen wel stellen. Het duurt nog wel even voordat de oude garde met pensioen is, een nieuwe generatie wetenschappers op machtsposities terechtkomt en we een echte cultuurverandering zullen zien.

Lees ook het interview met Nick Brown.